图文匹配算法的研究毕业论文

2020-04-01 11:01:50

摘 要

网络出版和自媒体高度发展的今天,互联网已经成为人们获取信息的重要来源。目前传统网络文章生产效率低下,而采用文本自动配图方法可以改善生产效率。本课题针对图文匹配问题研究图像向量化、文本向量化和图像向量与文本向量之间的相似性度量问题。图像向量化就是将图像映射到高维向量空间,每一维代表图像的某种特征,本课题采用卷积神经网络提取图像的特征向量;文本向量化也是将文本映射到高维向量空间,每一维代表文本的某种特征,本课题采用长短期记忆网络提取文本的特征向量;图像向量和文本向量的相似性度量是衡量图像向量和文本向量之间的距离,从而衡量图像和文本的相似度,本课题采用改进了余弦相似度的乘法距离来衡量图文向量相似度。在本课题实验中采用VGG19网络提取图像特征,采用Recall@K评价实验结果,和类似算法比较取得了较优的结果。

关键词:图文匹配;相似性度量;跨模态搜索;

Abstract

With the rapid development of online publishing and self-media, the Internet has become an important source of information for people. At present, the production efficiency of traditional web articles is low, and the use of automatic text matching methods can improve production efficiency. This paper researches image vectorization, text vectorization and similarity measurement between image vector and text vector. Image vectorization is to map the image to a high-dimensional vector space. Each dimension represents a certain feature of the image. The convolutional neural network is used to extract the feature vectors of the image in the paper. Text vectorization also maps the text to the high-dimensional vector space. The dimension represents a feature of the text. the long-short-term memory network is used to extract the feature vector of the text in the paper. The similarity measure between the image vector and the text vector is to measure the distance between the image vector and the text vector, so as to measure the similarity between the image and the text. This paper uses a multiplicative distance that improves the cosine similarity to measure the similarity of the graphic vector. In this experiment, VGG19 network is used to extract image features, and Recall@K is used to evaluate the experimental results. Compared with similar algorithms, better results are obtained.

Key Words:image-sentence macthing;Similarity measure;media retrieval

目录

摘 要 I

第1章 绪论 1

1.1 研究背景 1

1.2 研究目的及意义 2

1.3 研究现状 2

1.4 研究内容 3

第2章 数据集 4

2.1 Flickr8K数据集 4

2.1.1 数据集介绍 4

2.1.2 Flickr8K数据集内容 4

第3章 图像编码及文本编码 7

3.1数据预处理 7

3.2 卷积神经网络 8

3.4 长短期记忆循环神经网络 10

第4章 图像文本编码模型 12

4.1 相似性度量 12

4.1.1 相似性度量的基本性质 12

4.1.2 常用的相似性度量 12

4.2 图像-文本编码模型 14

4.2.1 理论依据 14

4.2.2 图像编码过程 15

4.2.3 文本编码过程 15

4.2.4 学习过程 15

4.2.5 验证过程 16

第5章 实验与结果分析 17

5.1 搭建实验平台 17

5.1.1 深度学习框架 17

5.1.2. Anaconda 17

5.1.3 搭建开发环境 18

5.2构建神经网路 18

5.2.1 VGG网络 18

5.2.2 Embedding 19

5.2.3 LSTM网络 20

5.3 实验设计 20

5.4 实验结果 21

5.4 结果分析 21

第6章 总结与展望 22

6.1 本文总结 22

6.2 未来展望 22

参考文献 23

致 谢 25

绪论

1.1 研究背景

我们正在迈向数字化时代。社会信息化、信息社会化以及信息的生产与消费极大地推进了信息化社会的发展。互联网——正是当前人们获取信息的主要来源,是人们生活,娱乐和工作的重要组成部分。然而,随着互联网的飞速发展,以及互联网的规模和数字信息的增长,信息数量呈现出了几何级数的增长,出现了信息过载、信息爆炸等现象。根据企鹅智酷在2016年出版的调查报告,大多数自媒体推送文章阅读量平均从12%跌至5%,读者数增长缓慢,甚至出现负增长。随着内容的激增,用户的注意力越来越少,90%读者关注了不到50个自媒体。而78.3%的读者的高频关注或置顶的自媒体数量少于5个。读者对很多已经关注账号推送的文章信息打开阅读的概率越来越小。读者点开推送文章的概率和完整阅读的概率在逐渐递减。

解决网络文章阅读率和完整阅读概率下降的现象,最重要的还是不断改进核心内容,让文章内容形式上更加有趣吸引眼球。而图像作为视觉元素的一种,其比文字更加吸引眼球,给文章配一幅合适的图可以达到一些文字所不能达到的效果:

- 带动读者情绪,让读者能够根据图片将文字描述的场景想象出来;

- 优化排版,大量的文字会让用户疲于阅读,而图像和文字结合排版可以调节用户视线,提高阅读兴趣;

- 承载更大的信息量,将一些数据用图表的方式呈现出来,不仅更加直观,而且表达精确,这是文字所不能达到的效果。

鉴于文章配图的上述优点,众多网络出版商和自媒体越来越重视文章配图问题,所以为一段好文配上一个内容契合又吸睛的图片就显得尤为重要。而现如今,编辑文章的效率还值得提高。发表一篇网络文章的流程通常是先写好文章再去网上搜图。而网络上图库众多,其图片更是海量,想要从中找到真正符合文章的配图十分困难,这也造成了好的网络文章的编辑效率低下。

近年来,关于提高网络文章生产效率的想法日益增多。有的自媒体通过选择优质的图片库,对图片库的图片分类来提升配图效率;有的则通过关键词组合筛选图片库内容,来缩小目标,达到提升效率的目的。更具前景的则是通过文本语义去匹配图片语义,语义之间的匹配可以使推荐的图片更精准、更符合文本的意思。

1.2 研究目的及意义

在如今的信息时代,随着碎片化阅读的现象越来越多,用户的耐性正在减少。为了增加用户粘性,提高文章阅读率,快速发表优质网络文章成为了自媒体的根本需求。

本课题采用卷积神经网络编码图像,采用循环神经网络编码文本[1],设计向量乘法模型估计图像向量和文本向量的相似性。对图像和文本分别采用不同的神经网络可改善特征提取效果,从而提高匹配效果。

本课题旨在利用神经网络构建图像-文本编码模型,用以衡量图片和文本的语义距离,从而为一段文本推荐与该文本语义最近的图片,以解决网络出版的自动配图问题。用图片和文本的语义距离来推荐图片,可以使推荐的图片与文本内容更加契合,从而提升自媒体的生产效率。

1.3 研究现状

图文匹配最早的主流技术是基于文本的图像搜索(Text-Based Image Retrieval, TBIR),其实现方式是通过对图像进行文字标注,通过文本匹配达到匹配目标图像的目的。这种匹配方式过程简单,速度快,但是图像标签需要人工标注,带有一定的主观性和不确定性,从而导致图文匹配度低。同时,随着互联网的高速发展,图像资源增长速度极快,人工标注耗时耗力,跟不上图像资源的增长速率。基于内容的图像搜索(Content-Based Image Retrieval, CBIR)随之提出,其通过自动提取图像视觉特征建立特征索引,从而在视觉特征上找出与目标图像相似的图像集[2]。其在检索过程中不需要额外的文本输入,以图搜图的结果也更加明显。

上世纪末,LeNet5的提出标志着卷积神经网络问世,但由于硬件上的限制,直到20世纪初,卷积神经网络才崭露头角,在图像识别方面取得了巨大成功。2014年,Karen Simonyan等提出了用更深的卷积神经网络来提取图像特征[3],并在2014年的ImageNet大型视觉识别挑战赛(ILSVRC)中的图像定位和分类项目中分别获得了第一名和第二名。

随着神经网络在图像特征提取方面取得突出成果,很多学者也研究了神经网络在图文匹配方面的应用,Andrea Frome在2013年提出的深度视觉语义嵌入模型,在这个模型中,将句子表示为词嵌入向量[4];Richard Socher等在2014年提出的语义依赖树递归神经网络,它构建了一个图像-文本空间,通过学习构建文本向量来不断接近图像向量[5];Junhua Mao等在2014年提出了多模态递归神经网络,通过优化预测多模态空间来预测下一个词的生成,从而用图像生成描述文本[6];Ryan Kiros等在2015年提出了统一化视觉语义嵌入与多模态神经语言模型,通过LSTM将文本和图像向量放在多模态空间嵌入,从而衡量文本与图像的语义距离[7]。

在相关应用方面,Google在2016年发布了基于深度学习的推荐图片聊天程序,该方法基于短句子的语义抽取,匹配多标签图像;Google在2016年还推出了另一种提取图像语义算法,可以生成图像描述,然后衡量生成描述和句子之间的距离。腾讯在QQ空间中也运用了自动配图的技术,采用抽取文本关键字,再根据关键字和图像标签相似度推荐图片,其效果跟图像标签好坏有直接关系。

1.4 研究内容

本课题主要研究图像编码、文本编码及编码相似度计算问题,比较多种图文匹配方案[8],提出基于神经网络的图像文本编码方案,在此基础上设计乘法模型,用以计算图像向量和文本向量的相似度。

围绕上述内容,主要实现以下目标:

- 利用卷积神经网络构建一个图像编码模型。图像编码模型通过提取图像特征将图像向量化,从而让图像和文本有可比较性。

- 通过循环神经网络构建一个文本编码模型。文本编码模型用于学习参数并让生成的文本特征向量靠近其描述的图像,从而使两者的向量在语义上接近。

- 设计一种衡量图片特征向量和文本特征向量的算法。通过该算法来衡量图片和文本之间的语义距离,从而为文本推荐更符合其语义的图片。

数据集

到目前为止,神经网络仍然是一种需要从大量数据中学习参数的方法。小样本学习尚未有破性的进展,所以数据集对基于神经网络的算法依旧非常重要。本章着重介绍本课题所用到的数据集。

2.1 Flickr8K数据集

本课题主要研究图像和文本之间的语义距离,在构建神经网络的过程中,需要学习图像特征向量和其对应的文本特征向量之间的关系。Flickr8K数据集[9]提供了8000组图像和其对应的描述,这些图像和其描述是经过筛选的有鲜明特征的组合,并且Flickr8K数据集还对任意图像文本组合给出了专家评分和人工评分。本节将介绍Flickr8K数据集构成及其数据特点。

2.1.1 数据集介绍

Flickr数据集是雅虎发布的一个巨大的数据集,包含一亿张图片和与之相关的元数据(标题、描述、标签)。Flickr8K数据集是Micah Hodosh等从Flickr数据集中精选出的图像和其对应的描述集合,确保每条文本都可以清晰的描述图像显示的实体和事件,数据集可以在https://forms.illinois.edu/sec/1713398申请下载。Flickr8K数据集被研究者们广泛应用于图像标注和基于句子的图像匹配研究中。本课题选择Flickr8K数据集也方便与其他研究结果比较。

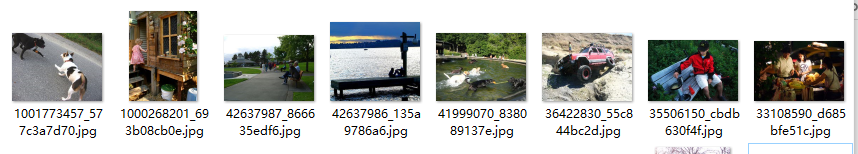

Flickr8K数据集由8000张图像组成,图像数据来源于雅虎的相册网站Flickr。其中的图像大多展示的是人类在参与到某项活动中的场景。每张图像对应五条人工标注的描述文本,每条描述采用不同的语法,清晰的表达了图像的语义。该数据集按照标准的训练集、验证集和测试集进行分块:6000张训练集、1000张验证集和1000张测试集。

2.1.2 Flickr8K数据集内容

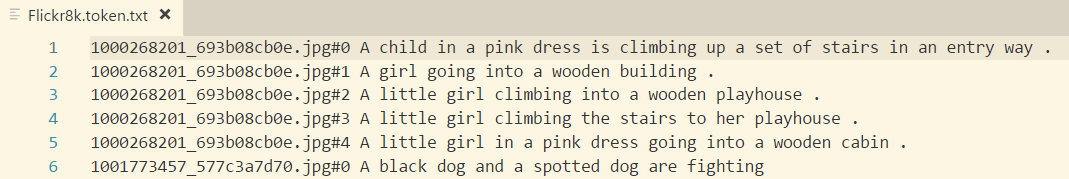

Flickr8K数据集给出的图像数据集如图2.1所示,8000张图像放在同一个文件夹下;给出的文本数据集包含在一个txt文本文件中,结构如图2.2所示。

图2.1 Flickr8K图像数据集

图2.2 Flickr8K文本数据集

在文本数据集文件中,每行对应一张图像和它的描述。由两个部分构成,第一部分形如“图像文件名#描述文本编号”,第二部分为描述语句。共有40000条文本。“图像文件名#描述文本编号”表示为该句子的ID。例如图2.2中第一行:

“1000268201_693b08cb0e.jpg#0”:本条句子的唯一ID;

“A child in a pink dress is……”:描述句子。

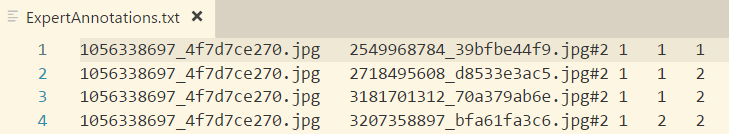

该数据集还给出了专家评分和CrowdFlower评分。如图2.3所示,专家评分文件每行对应一组图像-文本描述的评分,第一列是图像文件名,第二列是文描述ID(图像文件名#描述文本编号),接下来的三列是转接对该图文组合给出的评分,分数从1到4,其含义如下:

1分表示文本完全不能描述图片。

2分表示文本可以描述图片的很小一部分,但不能描述整个图片。

3分表示文本几乎可以描述整个图片,但有一些很小的错误。

4分表示文字完全描述了整个图片。

图2.3 Flickr8K专家评分

图2.4 Flickr8K CrowdFlower评分

CrowdFlower是一个众包平台,Flickr8K数据集给出了在平台的人工标注得分。如图2.4所示,该文本每行对应一组图像-文本描述的评分,第一列是图片名称,第二列是文本描述ID,第三列是Yes的百分数,第四列是Yes的总数,第五列是No的总数。Yes意味着文本可以描述图片(可能带有一些小错误),No表示文本不能描述图片。每组图像-文本描述至少有一个评分,有些组合可能有更多。

根据本课题的研究问题,在后续将会使用Flickr8k数据集中的图像数据和其对应的文本描述,由于本课题才用Recall@K评价体系,故不使用专家评分和CrowdFlower评分。

图像编码及文本编码

在图文匹配过程中,为了将图像和文本放在同一语义空间比较,需要将图像和文本进行编码。本章主要介绍利用卷积神经网络(CNN)进行图像特征向量提取[10],通过词嵌入和长短期记忆(LSTM)提取文本特征向量[11]。

3.1数据预处理

神经网络是一种从数据中学习参数的方法,因此,数据对于神经网络至关重要。而数据集提供的是初始数据,其质量、结构都不一样。因此需要对最开始的数据进行一些预处理。

在实际情况中,先对初始数据进行清洗,将质量不高、不符合研究内容的数据清除,由于本课题采用的Flickr8K数据集已经是清洗过的数据集,非常适合作为图文匹配研究的数据集,所以无需进行数据清洗。

其次需要调整数据的结构,在本课题中,需要将图像缩放到同一尺寸,以保证每个图像所表示的矩阵具有相同维度。由于图像的不同像素的尺度是一致的(0-255),所以不需要对图像进行归一化操作。

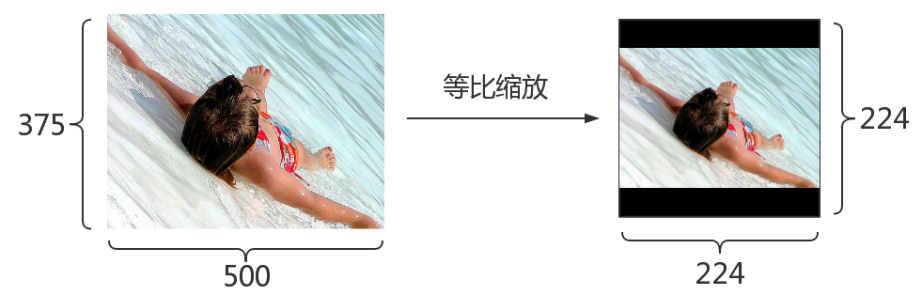

在本课题中,我们采用等比缩放,等比缩放是将原图像的长或宽中较长的一边匹配目标尺寸,然后等比例缩放。如原图像尺寸448*300,目标尺寸224*224,则用224/448得到缩放比,原图像缩放后变成224*150,剩下的像素位置用黑色填充,如图3.1所示。

利用卷积神经网络提取图像特征的方法通常接受244*244的图像作为输入,所以将Flickr8K数据集中的图像数据等比缩放到224*224,首先用矩阵的方式加载图像数据,通过计算缩放比调用resize方法对图像矩阵等比缩放,将缩放后的矩阵填入224*224*3矩阵,剩余像素位置填入0 。将矩阵以numpy矩阵的格式写入硬盘,以节省训练神经网络时将图片重新载入内存的时间。

课题毕业论文、开题报告、任务书、外文翻译、程序设计、图纸设计等资料可联系客服协助查找。